本文概述

人工神经网络(ANN)完全受生物神经系统工作方式的启发。例如, 人脑起作用。人脑最强大的属性是适应能力, 而人工神经网络具有类似的特征。我们应该明白, 我们的大脑到底是怎么做的?尽管我们对该程序有基本的了解, 但它仍然非常原始。公认的是, 在学习过程中, 大脑的神经结构被改变, 依赖于它们的活动来增加或减少其突触连接的能力。这就是为什么比很长一段时间未查看的信息更易于查看更相关的信息的原因。更多重要的信息将具有强大的突触联系, 而适用性较差的信息将逐渐削弱其突触联系, 从而使其难以审核。

ANN可以通过更改网络中神经元之间发现的加权关联来对这种学习过程进行建模。它有效地模仿了在我们大脑中发现的突触关联的增强和减弱。协会的加强和削弱是使网络适应的能力。人脸识别将是人类极其难以精确地转换为代码的一个问题示例。用学习算法无法更好地解决的问题是放贷机构, 它可以使用先前的信用评分对未来的贷款概率进行分类。

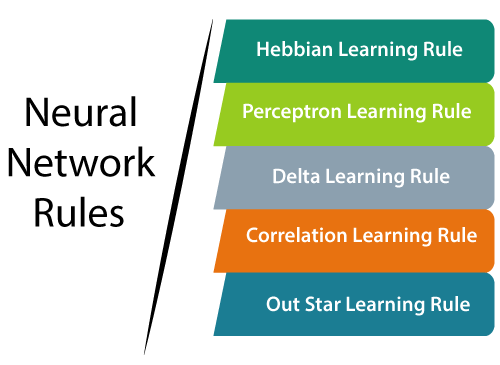

学习规则是一种鼓励神经网络从现有条件中受益并提升其性能的技术或数学逻辑。这是一个迭代过程。在本教程中, 我们将讨论神经网络中的学习规则。在这里, 我们将讨论什么是Hebbian学习规则, 感知学习规则, Delta学习规则, 相关学习规则, 外星学习规则?下面将详细讨论所有这些神经网络学习规则及其数学公式。

学习规则或学习过程是一种技术或数学逻辑。它提高了人工神经网络的性能, 并通过网络实施了该规则。因此, 当网络在特定数据环境中进行模拟时, 学习规则将刷新网络的权重和偏差级别。

赫比学习规则

赫比规则是主要的学习规则。 1949年, 唐纳德·赫布(Donald Hebb)创建了这种无监督神经网络的学习算法。我们可以使用此规则来识别如何提高网络节点的权重。

赫布学习法则认为, 如果相邻的神经元同时被激活和失活, 那么与这些神经元相关的权重就会增加。对于工作在相反阶段的神经元, 它们之间的重量应减小。如果没有输入信号关系, 则权重不应改变。

如果两个节点的输入为正或负, 则两个节点之间存在正权重。如果节点的输入对其他节点为正或为负, 则节点之间将存在可靠的负权重。

首先, 将所有权重的值设置为零。此学习规则可用于轻松激活功能和硬激活功能。由于在学习过程中未利用神经元的期望反应, 因此这是无监督的学习规则。权重的绝对值与学习时间成正比, 这是不希望的。

根据Hebbian学习规则, 以下给出了在每个时间范围内增加连接权重的公式。

Δωij(t)=αpi(t)* qj(t)

这里,

Δωij(t)=在时间函数t处权重的连接增加的增量。

α=恒定的正学习率。

pi(t)=在时间t处来自突触前神经元的输入值。

qj(t)=相同时间t的突触前神经元输出。

我们知道, 神经网络中的每个关联都具有关联的权重, 该权重在整个学习过程中都会发生变化。这是监督学习的一个示例, 网络通过为每个权重分配一个随机变量来开始学习。在这里, 我们可以基于一组记录来评估输出值, 对于这些记录, 我们可以知道预测的输出值。 Rosenblatt引入了此规则。此学习规则是有监督训练的示例, 其中通过一组适当的网络行为示例给出学习规则:

{X1, t1}, {x2, t2}, …, {xq, tq}

其中

Xq =网络输入。

tq =目标输出。

当将每个输入提供给网络时, 会将网络输出与网络目标进行比较。此后, 学习规则将改变权重并偏置网络, 以使网络输出更接近目标。

单神经元感知器:

在诸如分类, 模式识别和预测的不同计算机应用中, 学习模块可以通过包括结构, 统计和神经方法在内的不同方法来执行。在这些技术中, 人工神经网络受到大脑生理操作的启发。它们依赖于称为单个神经元感知器的单个神经细胞(神经元)的科学模型, 并试图类似于大脑中神经元的实际网络。

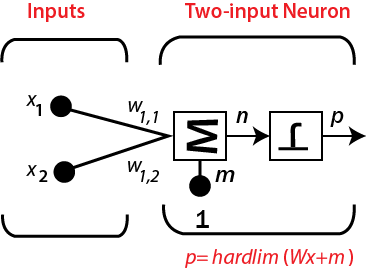

考虑带有一个神经元的两输入感知器, 如下图所示。

该网络的输出取决于

P = hardlim(n)= hardlim(Wx + m)

= hardlim(1wTx + m)= hardlim(w1, 1×1 + W1, 2×2 + m)

多神经元感知器:

对于具有多个神经元的感知器, 单个神经元将存在一个决策边界。神经元的决策边界将由

我wT x + mi = 0

单神经元感知器可以将输入矢量分为两类, 因为其输出可以为null或1。多神经元感知器可以将输入分为许多类。不同的输出矢量显示每个类。由于输出向量的每个分量可以为null或1, 因此总共有2S种可能的类别, 其中s是神经元的数量。

数学方程式:

为了描述其数学方程, 假定我们有n个有限输入向量x n以及其所需的输出向量t n, 其中n = 1到N。

如前所述, 可以基于净输入确定输出” k”, 并且可以将该净输入上应用的激活函数表示为:

K = f(Kin)= 1, kin>θ

0, kin≤θ

其中

θ=阈值。

可以针对这两种情况确定各种权重。

情况1-当t≠k时

w(新)= w(旧)+ tx

情况2 –当t = k时

体重不变

Delta学习规则

人工神经网络中的增量规则是一种特定类型的反向传播, 它有助于完善机器学习/人工智能网络, 使输入和输出之间的关联与人工神经元的不同层相关联。 Delta规则也称为Delta学习规则。

通常, 反向传播与使用梯度技术重新计算人工神经元的输入权重有关。 Delta学习通过使用目标激活和获得的激活之间的差异来实现此目的。通过使用线性激活功能, 可以平衡网络连接。解释Delta规则的另一种方法是, 它使用误差函数执行梯度下降学习。

增量规则是指将实际输出与目标输出进行比较, 技术尝试发现匹配项, 然后程序进行更改。 Delta规则的实际执行将根据网络及其组成而波动。尽管如此, 通过应用线性激活函数, delta规则对于细化特定种类的反向传播的几种神经网络仍然有用。

Delta规则由Widrow和Hoff引入, 这是最重要的学习规则, 它依赖于监督学习。

该规则指出, 节点权重的变化等效于误差与输入的乘积。

数学方程

给定的方程式给出了增量学习规则的数学方程式:

Δw= µx.z

Δw= µ(t-y)x

这里,

∆w =体重变化。

µ =恒定的正学习率。

X =突触前神经元的输入值。

z =(t-y)是所需输入t与实际输出y之差。上述数学规则只能用于单个输出单元。

可以针对这两种情况确定不同的权重。

情况1-当t≠k时

w(新)= w(旧)+ ∆w

情况2-当t = k时

体重不变

对于给定的输入向量, 我们需要比较输出向量, 最终的输出向量将是正确的答案。如果差异为零, 则不会进行学习, 因此我们需要调整权重以减小差异。如果一组输入模式是从一个独立的集合中获取的, 那么它将使用增量学习规则使用任意学习连接。它检查了具有线性激活功能且没有隐藏单元的网络。误差平方与权重图在n空间中是抛物面形状。比例常数为负, 因此该函数的图以最小的值向上凹。抛物面的顶点表示减小误差的点。权重向量将此点与理想权重向量进行比较。我们可以对单个输出单元和多个输出单元使用增量学习规则。当我们应用增量学习规则是为了减少实际输出与可能输出之间的差异时, 我们会发现一个错误。

相关学习规则

相关学习规则是基于与Hebbian学习规则相同的原理。它认为相应神经元之间的权重应为正, 具有逆反应的神经元之间的权重应为负。与Hebbian规则相反, 相关规则是监督学习。代替实际响应, 使用oj(期望响应), dj(用于权重计算)。

相关规则的数学公式如下:

Δwij=ɳXidj

训练算法通常从权重等于零的初始化开始。由于用户可以赋予所需的权重, 因此相关性学习规则是监督学习的一个示例。

其中

dj =输出信号的期望值。

明星学习法则

在星外学习规则中, 需要与特定节点关联的权重, 并且该权重应与与那些权重关联的神经元的期望输出相同。这是有监督的培训过程, 因为必须知道所需的输出。 Grossberg引入了Outstar学习规则。

Δwij= c(wij)

其中

di是所需的神经元输出。

c是小的学习常数, 在学习过程中会进一步减小。

srcmini

srcmini

评论前必须登录!

注册